L'essor de l'IA permet à Nvidia de se distinguer dans le secteur des puces- Plus USA

17 Mai 2023 - 9:56AM

Dow Jones News

SAN FRANCISCO (Agefi-Dow Jones)--Les ambitieux projets annoncés la

semaine dernière par Google dans le domaine de l'intelligence

artificielle (IA) générative sont pain béni pour un fabricant de

puces. Un.

Au cours d'une présentation qui a duré deux heures mercredi dernier

dans le cadre de sa conférence I/O pour les développeurs, Google a

tout fait pour mettre en avant l'utilisation de la puce H100 de

Nvidia, un processeur haut de gamme destiné aux centres de données

que le fabricant de semi-conducteurs n'a commencé à livrer que

cette année. Aucun autre fabricant de puces ni fournisseur de

composants pour centres de données n'a reçu pareille dédicace.

Et Google n'est pas le seul à en faire étalage. Le directeur

général de Microsoft, Satya Nadella, a lui aussi pris bien soin de

mentionner Nvidia le mois dernier, à l'occasion de la conférence

téléphonique de présentation des résultats du groupe, pour

renforcer son argument selon lequel Microsoft dispose "de

l'infrastructure d'IA la plus puissante" pour entraîner les grands

modèles de données. Là encore, aucun autre fabricant de

semi-conducteurs n'a été cité.

C'est une aubaine pour Nvidia, fabricant de puces le mieux valorisé

du marché. Le groupe a déjà vu sa capitalisation boursière presque

doubler depuis le début de l'année.

Lors de la publication de ses propres résultats, prévue ce mois-ci,

Nvidia devrait faire état d'une hausse de 4% sur un an de son

chiffre d'affaires lié aux centres de données, à 3,9 milliards de

dollars, pour le trimestre clos à la fin avril. Cela peut paraître

un peu mince pour une division qui avait enregistré une croissance

à deux chiffres l'an dernier, mais par rapport au plongeon de 38%

accusé par le segment centre de données d'Intel lors du trimestre

fini en mars, le résultat paraît presque honorable. Même Advanced

Micro Devices, qui rattrape Intel sur son marché clé, a enregistré

une croissance plus ou moins nulle dans son activité de centres de

données sur le trimestre clos en mars et le groupe anticipe de

surcroît un repli pour le trimestre en cours.

Des dépenses d'investissement en baisse

L'avantage de Nvidia provient de ses processeurs graphiques,

spécifiquement conçus pour l'IA. Or les géants de la tech comme

Google, Microsoft, Amazon et Meta Platforms étant maintenant lancés

dans la course au développement de technologies d'IA générative du

type ChatGPT, ils ont besoin de composants tels que la puce H100 de

Nvidia. Ces mêmes entreprises sont toutefois confrontées dans le

même temps à un ralentissement de leurs activités stratégiques et

sont donc sous pression pour freiner leurs dépenses

d'investissement.

Les dépenses d'investissement cumulées des quatre groupes

susmentionnés ont diminué de 4% sur un an au cours du trimestre

clos en mars : il s'agit du premier repli depuis quatre ans. La

société de recherche Dell'Oro Group prévoit que les dépenses

d'investissement propres aux centres de données augmenteront

d'environ 5% cette année, après une envolée de 36% en 2022.

Néanmoins, l'impact de ce ralentissement ne sera pas uniformément

ressenti. La nécessité d'investir dans des puces onéreuses comme la

H100 de Nvidia pour alimenter les offres d'IA générative implique

de diminuer d'autres dépenses liées aux centres de données. "Il

apparaît très clairement que les clients consolident leurs achats

de serveurs traditionnels afin de libérer une partie de leur budget

pour les serveurs GPU qui coûtent 20 fois plus", constate Joe

Moore, analyste chez Morgan Stanley, dans un rapport publié

vendredi.

Le projet de Google d'intégrer des fonctions d'agent

conversationnel à son activité de recherche sur Internet est à lui

seul extrêmement coûteux. Pierre Ferragu, chez New Street Research,

estime qu'alimenter toutes les recherches Google avec des puces

Nvidia représenterait des dépenses d'investissement supplémentaires

de 80 milliards de dollars, même s'il ajoute s'attendre à ce que le

groupe compense une partie de ces besoins avec ses propres puces

TPU, fabriquées en interne.

L'envolée des achats de puces réalisés l'an dernier devrait encore

soutenir d'autres fabricants de semi-conducteurs pour centres de

données. Joe Moore, de Morgan Stanley, note que l'opportunité que

représente l'IA pour AMD est plus importante que prévu : l'analyste

estimait précédemment que l'IA représenterait pour le fabricant de

puces un chiffre d'affaires de 100 millions de dollars en 2024. Joe

Moore table maintenant sur un montant de l'ordre de 400 millions de

dollars.

Reste que les gains générés par l'IA seront l'un des rares points

positifs dont bénéficiera le secteur, qui reste confronté à une

véritable chute des ventes. La Semiconductor Industry Association a

indiqué ce mois-ci que les ventes avaient reculé de 21% en mars par

rapport au même mois de 2022, soit la plus forte baisse mensuelle

accusée par le secteur depuis 2009.

Le dernier ralentissement majeur observé par l'association a duré

13 mois, tandis que le ralentissement actuel a commencé il y a huit

mois. Même la trésorerie des géants de la tech a ses limites.

-Dan Gallagher, The Wall Street Journal

(Version française Emilie Palvadeau) ed: VLV

Agefi-Dow Jones The financial newswire

(END) Dow Jones Newswires

May 17, 2023 03:36 ET (07:36 GMT)

Copyright (c) 2023 L'AGEFI SA

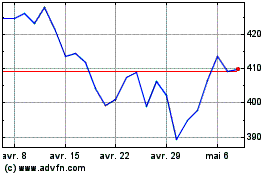

Microsoft (NASDAQ:MSFT)

Graphique Historique de l'Action

De Nov 2024 à Déc 2024

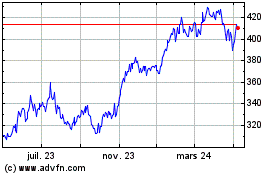

Microsoft (NASDAQ:MSFT)

Graphique Historique de l'Action

De Déc 2023 à Déc 2024